Redes Neurais

Afluentes:

Histórico

As Redes Neurais Artificiais surgiram na década de 40, mais precisamente em 1943, quando o neurofisiologista Warren McCulloch e o matemático Walter Pitts, da Universidade de Illinois, fizeram uma analogia entre as células nervosas e o processo eletrônico num artigo publicado no Bulletin of Mathematical Biophysics com o título: A Logical Calculus of the Ideas Immanent in Nervous Activity.

Em 1949, o biólogo e psicólogo Donald Hebb, que estudava o comportamento dos animais, escreveu um livro chamado The Organization of Behavior, que reforçava as teorias de que o condicionamento psicológico estava presente em qualquer parte dos animais, pelo fato de que esta é uma propriedade de neurônios individuais. As idéias de Hebb não eram pioneiras, mas ele propôs um princípio de aprendizado em sistemas nervosos complexos, ou seja, uma lei que descreve o funcionamento quantitativo da sinapse e do processo de treinamento humano.

Desde, então, vários outros pesquisadores, entusiasmados com as novas descobertas, voltaram-se para esta linha de pesquisa.

Em 1951, Marvin Minsky, co-fundador do Laboratório de Inteligência Artificial do MIT, construiu o SNARC, o primeiro simulador de cadeia neural. O SNARC trabalhava com êxito e podia ajustar seus pesos sinápticos automaticamente. Ele nunca chegou a executar alguma função de processamento de informação interessante, servindo somente de fator motivador para idéias que surgiram posteriormente.

Em 1956, na Primeira Conferência Internacional de Inteligência Artificial, foi apresentado um modelo de rede neural artificial pelo pesquisador da IBM Nathaniel Rochester. Seu modelo consistia numa simulação de centenas de neurônios interconectados através de um sistema que verificaria como a rede responderia aos estímulos ambientais.

Já em 1959, Frank Rosenblatt na Universidade de Cornell, criou uma rede de múltiplos neurônios do tipo discriminadores lineares e a batizou de rede perceptron. Rosenblatt baseou-se nas linhas de pensamento de McCulloch para desenvolver o seu modelo matemático de sinapse humana. Devido as suas complexas pesquisas e inúmeras contribuições técnicas, muitos o consideram como fundador da neurocomputação.

No final da década de 50, Minsky e Seymour Papert lançaram em uma obra chamada Perceptron, a qual demonstrava que o modelo apresentado por Rosenblatt não era muito promissor, devido ao uso de técnicas empíricas, das grandes dificuldades da matemática envolvida e dos poucos recursos computacionais disponíveis na época. A publicação de Minsky e Papert acabou esfriando as pesquisas e praticamente todo o investimento financeiro nesta área foi cancelado.

Enquanto Rosenblatt trabalhava no perceptron, Bernard Widrow da Universidade de Stanford com a ajuda de alguns estudantes desenvolveu um novo modelo de processamento de redes neurais chamado de Adaline (ADAptive LINear Elemtent), a qual se destacava pela sua poderosa lei de aprendizado. O princípio de treinamento para as redes Adalines ficou conhecido como a Regra Delta, que foi mais tarde generalizada para redes com modelos neurais mais sofisticados. Mais tarde, Widrow criou a Madaline, que era uma generalização múltidimensional do adaline.

Nos anos seguintes, muitos artigos foram publicados, e várias previsões exageradas e pouco confiáveis para a época foram anunciadas [TAFb 96]. A maioria destas suposições falava de computadores com um poder de raciocínio e/ou processamento igual ou superior ao do cérebro humano. Desta forma, a credibilidade de futuros estudos das RNA's foram fortemente comprometidos.

No início da década de 80, muitos pesquisadores publicaram inúmeras propostas para a exploração de desenvolvimento e pesquisa em redes neurais. Foi quando o administrador de programas da DARPA (Defense Advanced Research Projects Agency) Ira Skurnick resolveu dar atenção às proposições da neurocomputação, contrariando todos os preceitos, fundando em 1983 as pesquisas em neurocomputação da DARPA. Este fato acabou abrindo novos horizontes para a neurocomputação.

O físico e biólogo de reputação mundial John Hopfield também se interessou pela neurocomputação e escreveu vários artigos em 1982 que levaram vários cientistas a se unirem nesta nova área emergente. Hopfield reascendeu as pesquisas em neurocomputação, criticando fortemente as teorias apresentadas por Minsky e Papert na década de 50.

Este campo de pesquisa explodiu mesmo em 1986, quando o professor de psicologia da Universidade de Stanford, David E. Rumelhart, e seu colega James L. McClelland, professor de psicologia da Universidade de CarnegieMellon, publicaram o livro Parallel Distributed Processing: Explorations in the Microstructure of Cognition (vol.1: Foundations, vol.2: Psychological and Biological Models). Nesse livro, eles apresentam um modelo matemático e computacional que propicia o treinamento supervisionado dos neurônios artificiais. Surgia, então, o algoritmo backpropagation, um algoritmo de otimização global sem restrições.

Em 1987 ocorreu a Primeira Conferência de Redes Neurais. Também foi formada a Sociedade Internacional de Redes Neurais (International Neural Networks Society - INNS) juntamente com o INNS Journal em 1989, do Neural Computation e do IEEE Transactions on Neural Networks em 1990.

A partir destes acontecimentos, muitas instituições formaram institutos de pesquisa e programas de educação em neurocomputação.

Fundamentação Biológica

O Sistema Nervoso Humano

|

O cérebro humano é uma rede de mais de 100 bilhões de células nervosas que se interconectam, via conexões sinápticas, para produzirem a percepção humana do mundo exterior, o mecanísmo de ação e o processo mental do indivídulo. As células nervosas se comunicam via transmissão sináptica.

A Neurociência procura explicações da conduta em termos de atividades do encéfalo, explicar como atuam os milhões de células nervosas individuais no encéfalo para produzir a conduta e como, por sua vez, estas células estão influenciadas pelo meio ambiente, incluindo a conduta de outros indivíduos.

Os indivídulos encéfalos obtêm informaçãos sobre o seu meio através de vários receptores sensoriais. Essas informações se transforma em percepções ou ordens para atuar no meio em que se encontram. No caso do "arco reflexo", após uma percepção ocorrida pelo indivídulo, uma resposta é elaborada e interpretada pelos centros nervosos superiores, Arco Reflexo Central. Já um reflexo de sobrevivência (saltar durante um susto, retirar a mão de uma superfície quente, reflexo patelar, etc...) são respostas imediatas, sem interpretação detalhada e coordenadas pela medula espinhal, sendo denominadas de Arco Reflexo Periférico.

O sistema nervoso, juntamente com o sistema endócrino, capacitam o organismo a perceber as variações do meio (interno e externo), a difundir as modificações que essas variações produzem e a executar as respostas adequadas para que seja mantido o equilíbrio interno do corpo (homeostase). São os sistemas envolvidos na coordenação e regulação das funções corporais.

No sistema nervoso diferenciam-se duas linhagens celulares: os neurônios e as células da glia (ou da neuróglia). Os neurônios são as células responsáveis pela recepção e transmissão dos estímulos do meio (interno e externo), possibilitando ao organismo a execução de respostas adequadas para a manutenção da homeostase. Para exercerem tais funções, contam com duas propriedades fundamentais: a irritabilidade (também denominada excitabilidade ou responsividade) e a condutibilidade. Irritabilidade é a capacidade que permite a uma célula responder a estímulos, sejam eles internos ou externos. Portanto, irritabilidade não é uma resposta, mas a propriedade que torna a célula apta a responder. Essa propriedade é inerente aos vários tipos celulares do organismo. No entanto, as respostas emitidas pelos tipos celulares distintos também diferem umas das outras. A resposta emitida pelos neurônios assemelha-se a uma corrente elétrica transmitida ao longo de um fio condutor: uma vez excitados pelos estímulos, os neurônios transmitem essa onda de excitação - chamada de impulso nervoso - por toda a sua extensão em grande velocidade e em um curto espaço de tempo. Esse fenômeno deve-se à propriedade de condutibilidade.

|

Os corpos celulares dos neurônios são geralmente encontrados em áreas restritas do sistema nervoso, que formam o Sistema Nervoso Central (SNC), ou nos gânglios nervosos, localizados próximo da coluna vertebral.

Do sistema nervoso central partem os prolongamentos dos neurônios, formando feixes chamados nervos, que constituem o Sistema Nervoso Periférico (SNP).

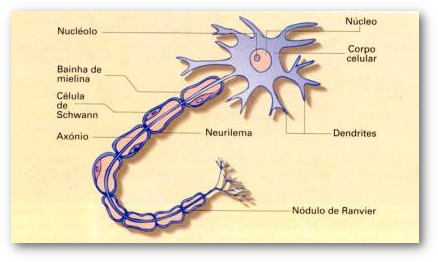

O axônio está envolvido por um dos tipos celulares seguintes: célula de Schwann (encontrada apenas no SNP) ou oligodendrócito (encontrado apenas no SNC) Em muitos axônios, esses tipos celulares determinam a formação da bainha de mielina - invólucro principalmente lipídico (também possui como constituinte a chamada proteína básica da mielina) que atua como isolante térmico e facilita a transmissão do impulso nervoso. Em axônios mielinizados existem regiões de descontinuidade da bainha de mielina, que acarretam a existência de uma constrição (estrangulamento) denominada nódulo de Ranvier. No caso dos axônios mielinizados envolvidos pelas células de Schwann, a parte celular da bainha de mielina, onde estão o citoplasma e o núcleo desta célula, constitui o chamado neurilema.

O Neurônio

As unidades básicas do encéfalo são as células nervosas (Figura 1), que por si só são muito simples. Porém, devido à grande quantidade de conexões de um milhares de células nervosa, o encéfalo é capaz de gerar comportamentos bastantes complexos. As células nervosas apesar de sua grande quantidade compartem muitas características. Foi descoberto que o potencial de ação para produzir condutas complexas não depende da variedade das células nervosas, mas sim de seu número e de suas conexões.

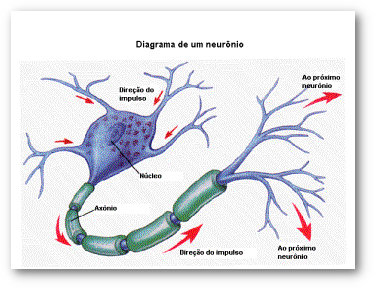

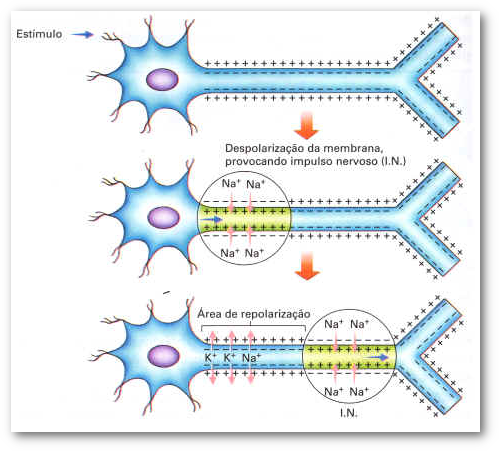

A Sinapse é a comunicação entre um neurônio e outro(s), ou outros tecidos. A condução de um estímulo elétrico pela membrana celular de um neurônio é unidirecional (Figura 2), sempre no sentido dendrito è corpo celular è axônio. Assim, o elemento que fica antes da comunicação (sinapse) celular é denominado pré-sináptico e o que fica depois de pós-sináptico.

O espaço entre o elemento pré-sináptico e o pós-sináptico é denominado de fenda sináptica e é onde são liberados os mediadores químicos inibidores ou excitadores de membrana.

O Impulso Nervoso

A membrana plasmática do neurônio transporta alguns íons ativamente, do líquido extracelular para o interior da fibra, e outros, do interior, de volta ao líquido extracelular. Assim funciona a bomba de sódio e potássio, que bombeia ativamente o sódio para fora, enquanto o potássio é bombeado ativamente para dentro.Porém esse bombeamento não é equitativo: para cada três íons sódio bombeados para o líquido extracelular, apenas dois íons potássio são bombeados para o líquido intracelular.

Imediatamente após a onda de despolarização ter-se propagado ao longo da fibra nervosa, o interior da fibra torna-se carregado positivamente, porque um grande número de íons sódio se difundiu para o interior. Essa positividade determina a parada do fluxo de íons sódio para o interior da fibra, fazendo com que a membrana se torne novamente impermeável a esses íons.

Por outro lado, a membrana torna-se ainda mais permeável ao potássio, que migra para o meio interno. Devido à alta concentração desse íon no interior, muitos íons se difundem, então, para o lado de fora. Isso cria novamente eletronegatividade no interior da membrana e positividade no exterior – processo chamado repolarização, pelo qual se reestabelece a polaridade normal da membrana.

A repolarização normalmente se inicia no mesmo ponto onde se originou a despolarização, propagando-se ao longo da fibra. Após a repolarização, a bomba de sódio bombeia novamente os íons sódio para o exterior da membrana, criando um déficit extra de cargas positivas no interior da membrana, que se torna temporariamente mais negativo do que o normal.

A eletronegatividade excessiva no interior atrai íons potássio de volta para o interior (por difusão e por transporte ativo). Assim, o processo traz as diferenças iônicas de volta aos seus níveis originais.

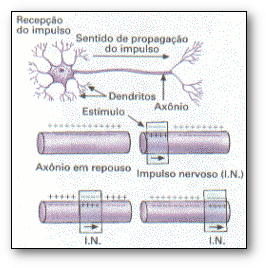

Para transferir informação de um ponto para outro no sistema nervoso, é necessário que o potencial de ação, uma vez gerado, seja conduzido ao longo do axônio. Um potencial de ação iniciado em uma extremidade de um axônio apenas se propaga em uma direção, não retornando pelo caminho já percorrido.

Conseqüentemente, os potenciais de ação são unidirecionais - ao que chamamos condução ortodrômica. Uma vez que a membrana axonal é excitável ao longo de toda sua extensão, o potencial de ação se propagará sem decaimento.

A velocidade com a qual o potencial de ação se propaga ao longo do axônio depende de quão longe a despolarização é projetada à frente do potencial de ação, o que, por sua vez, depende de certas características físicas do axônio: a velocidade de condução do potencial de ação aumenta com o diâmetro axonal. Axônios com menor diâmetro necessitam de uma maior despolarização para alcançar o limiar do potencial de ação. Nesses de axônios, presença de bainha de mielina (Figura 5) acelera a velocidade da condução do impulso nervoso. Nas regiões dos nódulos de Ranvier, a onda de despolarização "salta" diretamente de um nódulo para outro, não acontecendo em toda a extensão da região mielinizada (a mielina é isolante). Fala-se em condução saltatória e com isso há um considerável aumento da velocidade do impulso nervoso.